Participa con tu nota. Contacto: [email protected]

Editorial

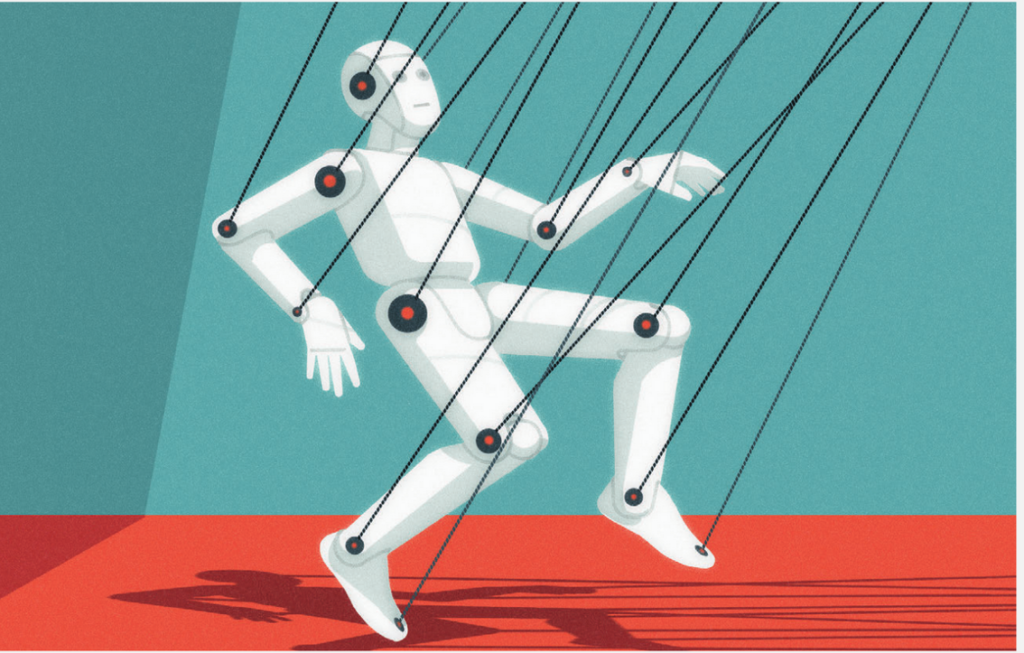

Regular la IA: ¿control, panóptico o negocio?

El año 2023 ha tenido un avance notable no tanto en las tecnologías inteligentes como en las preocupaciones que estos avances generan.

La industria ha lanzado unos mal proclamados chatterbots, sistemas basados en aprendizaje automático que han sido administrados de manera tal que, como explica la especialista Eliza Strickland, han logrado inundar al mundo de lenguaje tóxico, desinformación sistemática. Más recientemente también se observa la emergente dependencia de muchas personas, posiblemente guiada por el hedonismo que puede surgir en ocasiones en el propio humano.

Strickland explica claramente que las decisiones automáticas esconden discriminaciones contra ciertos grupos, y la falta de transparencia en muchos de estos sistemas inteligentes complican aún más este problema.

Si bien podría ser un poco dramático, el verdadero inconveniente no deviene de un tratamiento universal como algunos plantean, sino de un tratamiento global que respete las culturas y necesidades locales.

En abril de 2021 la sede estadounidense de la Comisión Europea propuso un tratamiento de los riesgos en diversas áreas como las finanzas, justicia y medicina. Curiosamente, no ponen acento en las desigualdades de género o por sesgo cultural. Tampoco lo hace la propia Eliza en su artículo.

En junio de 2023 el parlamento europeo votó una legislación provisoria. Pero como era de prever, emergieron desacuerdos y las negociaciones no tardaron en presentarse, ya que en el fondo las implicaciones económicas y financieras son importantes.

Como validando la necesidad de una posición centralista y hegemónica, Strickland presenta como ejemplo el caso de China, donde ya existen regulaciones precisas, que se han impuesto y afectan desde la capacidad de generar algoritmos hasta la vida social del individuo.

En franca contradicción con este mismo propuesto ejemplo la autora luego expresa como «preocupación común» central a estas regulaciones tan solo a un limitado tipo de IAs: las que se implementan con motivo de derivar contenidos automáticamente. Esto deja paradójicamente a los sistemas de armamento inteligente fuera de la explícita restricción o nominación de ilegalidad. En un segundo plano también alcanza a introducir las reglas para las herramientas inteligentes, pero siguen quedando fuera de la mira las más letales implementaciones de los controles inteligentes en armamentos, que ya tienen existencia (y desde hace años) en misiles y armas de diversos tipos y niveles de letalidad.

Hoy, desde esta perspectiva, un dron miniatura con una carga explosiva que penetre el cráneo de una persona seguiría siendo legal, pero una herramienta inteligente que ayude a aprender cómo generar un chatterbot inteligente sería ilegal.

El artículo promedia hablando de las industrias y sus reclamos de una regulación coherente y en solo un renglón presenta tímidamente lo que sería el centro de la cuestión: cómo afecta la IA y su control en las regulaciones locales, y en las unicidades de cada país, región e individuo.

Como comentario final, el artículo solo menciona que el problema afecta a nivel global, pero trabaja con solo unos cuantos países. En cambio, deja sin evaluar los aspectos de género, sociales y culturales de América Latina y de muchas de las minorías invisibilizadas. Por caso: ¿una silla de ruedas inteligente necesitará una habilitación legal por parte de una entidad central que certifique que no es peligrosa?

Daniela López De Luise

Academia Nacional de Ciencias de Buenos Aires

Coordinadora Académica CETI

[1]Editorial del Artículo original Europe and China Solidify AI Regulation. Sect. The latest developments in technology, engineering, and science(Eliza Strickland). IEEE Spectrum n23. Sept 2023. pp. 9-11