Periodista por un día > Funcionamiento del Cerebro e Inteligencia Artificial

Publicado el 16 de octubre de 2021

Funcionamiento del Cerebro e Inteligencia Artificial

Revelan nuevos aspectos para considerar en los modelos de Redes Neuronales Artificiales.

La Inteligencia Artificial (IA) requiere realizar cambios profundos en sus modelos de Redes Neuronales para simular realmente cómo funciona el cerebro.

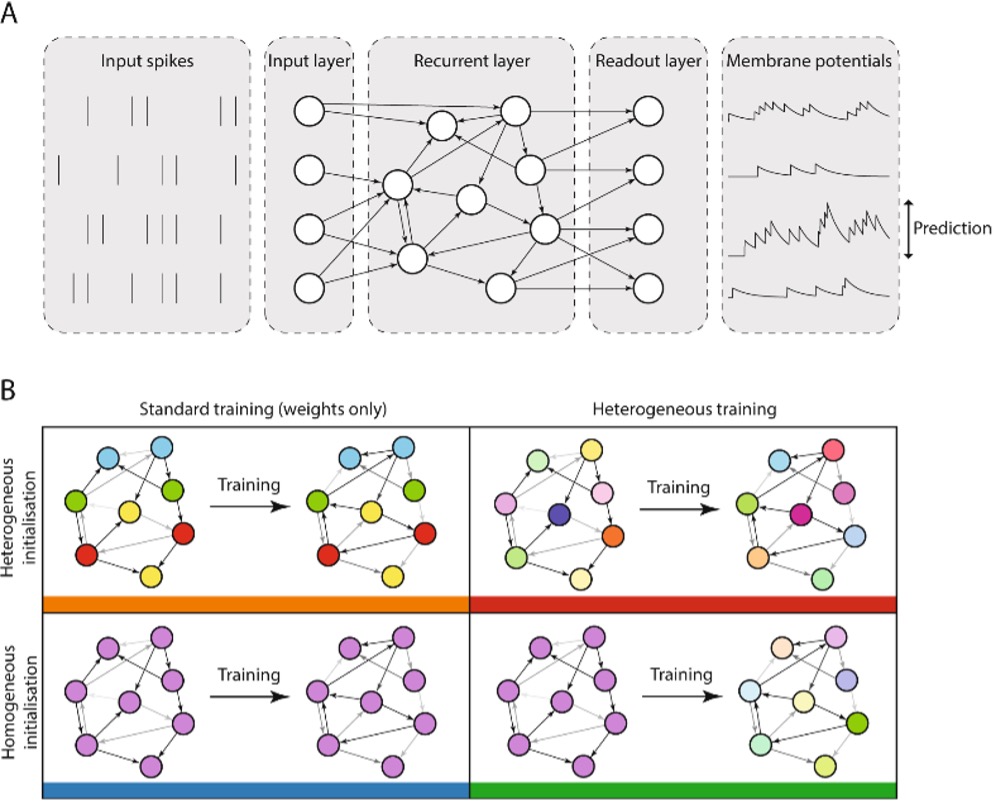

El nuevo estudio prueba que además de la plasticidad y la característica Todo o Nada de las neuronas artificiales, se necesita considerar otros aspectos. El estudio encontró que al ajustar las propiedades eléctricas, las redes aprendieron más rápido que las simulaciones donde todas las células son iguales. También encontraron que se requieren menos células para obtener los mismos resultados.

Los autores sostienen que sus hallazgos podrían enseñarnos por qué nuestros cerebros son tan buenos para aprender, como así también ayudarnos a construir mejores sistemas de Inteligencia Artificial para reconocer voces, rostros, o incorporar tecnología de automóviles autónomos.

Nicolás Pérez (Primer autor del artículo), estudiante de doctorado en Imperial College de Londres, dijo: «El cerebro necesita ser energéticamente eficiente y al mismo tiempo ser capaz de sobresalir en la resolución de tareas complejas. Nuestro trabajo sugiere que tener una diversidad de neuronas en tanto los cerebros como los sistemas de inteligencia artificial cumplen ambos requisitos y podrían impulsar el aprendizaje«.

El cerebro está formado por miles de millones de neuronas conectadas por vastas ‘redes neuronales’. Las neuronas se ven iguales desde la distancia, pero en una inspección más profunda no hay dos exactamente iguales. Por el contrario, cada célula de una red neuronal artificial es idéntica, y solo varía por su conectividad. A pesar de la rapidez con la que avanza la tecnología de IA, sus redes neuronales no aprenden con tanta precisión y rapidez como el cerebro humano. Los investigadores descubrieron que la variabilidad en las células mejoró su aprendizaje y redujo el consumo de energía.

El Dr. Dan Goodman, uno de los autores del artículo y perteneciente al Departamento de Ingeniería Eléctrica y Electrónica de Imperial College de Londres, dijo: «La evolución nos ha proporcionado funciones cerebrales increíbles, la mayoría de las cuales apenas estamos comenzando a comprender. Nuestra investigación sugiere que podemos aprender lecciones vitales de las nuestras biología para hacer que la IA funcione mejor para nosotros«.

Otro aspecto que se consideró fue ajustar la «constante de tiempo», es decir, la rapidez con la que cada célula decide lo que quiere hacer en función de lo que están haciendo las células conectadas a ella. Los resultados muestran que al permitir que la red combine información lenta y rápida, pudo resolver mejor las tareas en entornos de mayor complejidad del mundo real. Cuando cambiaron la cantidad de variabilidad en las redes simuladas, encontraron que las que funcionaron mejor coincidían con la cantidad de variabilidad observada en el cerebro, lo que sugiere que el cerebro puede haber evolucionado para tener la cantidad justa de variabilidad para un aprendizaje óptimo.

Nicolas agregó: «Demostramos que la IA puede acercarse a cómo funciona nuestro cerebro emulando ciertas propiedades cerebrales. Sin embargo, los sistemas de IA actuales están lejos de alcanzar el nivel de eficiencia energética que encontramos en los sistemas biológicos«. Esta investigación fue financiada por el Consejo de Investigación de Ingeniería y Ciencias Físicas y la Beca de Doctorado del Presidente del Imperial College.

Fuente:

- Perez-Nieves N, Leung VCH, Dragotti PL, Goodman DFM. Neural heterogeneity promotes robust learning. Nat Commun. 2021 Oct 4;12(1):5791. doi: 10.1038/s41467-021-26022-3. PMID: 34608134; PMCID: PMC8490404.

Adaptado por:

Rapallini Ulises M. A.

Email: ulises.rapallini@gmail.com

IEEE CIS Argentina